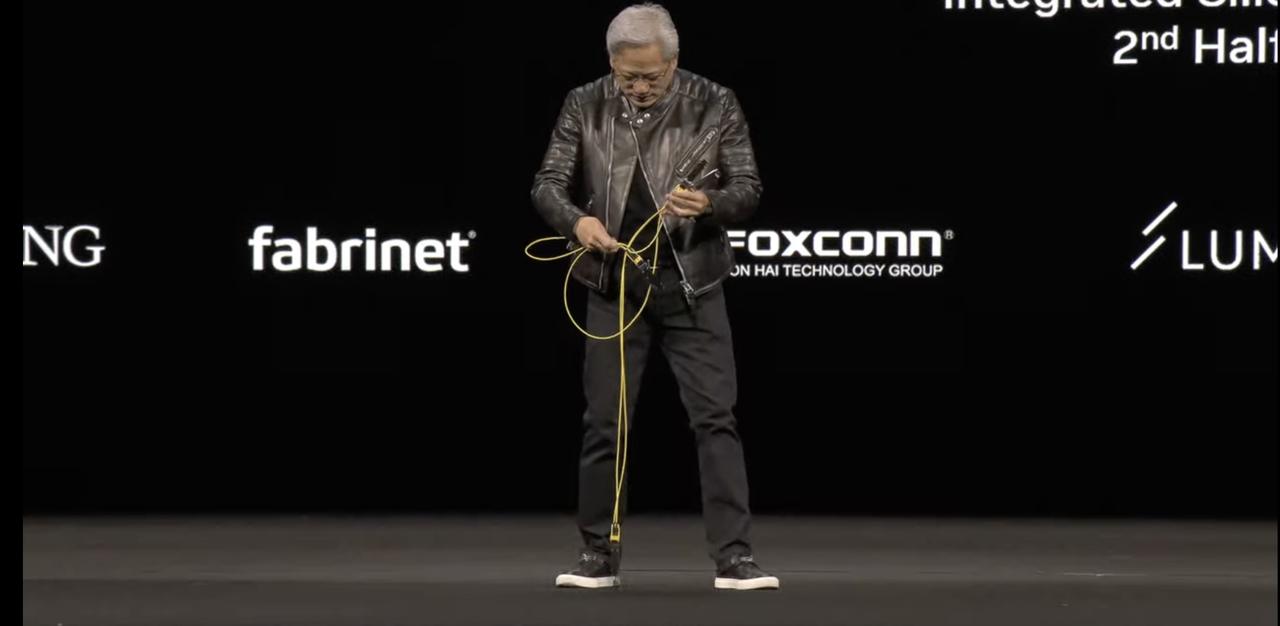

英偉達 GTC 大會已經成了 AI 界超級碗,沒有劇本也沒有提詞器,中途黃仁勛被線纜卡住,反而是這場高濃度 AI 發布會里最有人味的片段,在當今提前基本提前彩排或錄播的科技發布會里已經很稀缺了。

剛剛,黃仁勛再次發布了全新一代核彈級 AI 芯片,不過這場發布會的還有個隱藏主角——DeepSeek。

由于智能體 AI(Agentic AI)和推理能力的提升,現在所需的計算量至少是去年此時預估的 100 倍。

推理成本效率給 AI 行業帶來影響,而不是簡單地堆積計算能力,成為貫穿這場發布會的主線。英偉達要變成 AI 工廠,讓 AI 以超越人類的速度學習和推理。

推理本質上是一座工廠在生產 token,而工廠的價值取決于能否創造收入和利潤。因此,這座工廠必須以極致的效率打造。

黃仁勛掏出的英偉達新「核彈」也在告訴我們,未來的人工智能競爭不在于誰的模型更大,而在于誰的模型具有最低的推理成本和更高推理的效率。

除了全新 Blackwell 芯片,還有兩款「真·AI PC」

全新的 Blackwell 芯片代號為「Ultra」,也就是 GB300 AI 芯片,接棒去年的「全球最強 AI 芯片」B200,再一次實現性能上的突破.

Blackwell Ultra 將包括英偉達 GB300 NVL72 機架級解決方案,以及英偉達 HGX B300 NVL16 系統。

Blackwell Ultra GB300 NVL72 將于今年下半年發布,參數細節如下:

- 1.1 EF FP4 Inference:在進行 FP4 精度的推理任務時,能夠達到 1.1 ExaFLOPS(每秒百億億次浮點運算)。

- 0.36 EF FP8 Training:在進行 FP8 精度的訓練任務時,性能為 1.2 ExaFLOPS。

- 1.5X GB300 NVL72:與 GB200 NVL72 相比,性能為 1.5 倍。

- 20 TB HBM3:配備了 20TB HBM 內存,是前代的 1.5 倍

- 40 TB Fast Memory:擁有 40TB 的快速內存,是前代的 1.5 倍。

- 14.4 TB/s CX8:支持 CX8,帶寬為 14.4 TB/s,是前代的 2 倍。

單個 Blackwell Ultra 芯片將和前代一樣提供相同的 20 petaflops(每秒千萬億次浮點運算) AI 性能,但配備更多的 288GB 的 HBM3e 內存。

如果說 H100 更適合大規模模型訓練,B200 在推理任務中表現出色,那么 B300 則是一個多功能平臺,預訓練、后訓練和 AI 推理都不在話下。

英偉達還特別指出,Blackwell Ultra 也適用于 AI 智能體,以及用于訓練機器人和汽車自動駕駛的「物理 AI」。

為了進一步增強系統性能,Blackwell Ultra 還將與英偉達的 Spectrum-X 以太網和英偉達 Quantum-X800 InfiniBand 平臺集成,為系統中的每個 GPU 提供 800Gb/s 的數量吞吐量,幫助 AI 工廠和云數據中心能夠更快處理 AI 推理模型。

除了 NVL72 機架,英偉達還推出了包含單個 GB300 Blackwell Ultra 芯片的臺式電腦 DGX Station。Blackwell Ultra 之外,這個主機還將配備 784GB 的同一系統內存,內置 800Gbps 英偉達 ConnectX-8 SuperNIC 網絡,能夠支持 20 petaflops 的 AI 性能。

而之前在 CES 2025 展示的「迷你主機」Project DIGITS 也正式被命名為 DGX Spark,搭載專為桌面優化的 GB10 Grace Blackwell 超級芯片,每秒可提供高達 1000 萬億次 AI 計算操作,用于最新 AI 推理模型的微調和推理,包括 NVIDIA Cosmos Reason 世界基礎模型和 NVIDIA GR00T N1 機器人基礎模型。

黃仁勛表示,借助 DGX Station 和 DGX Spark,用戶可以在本地運行大模型,或者將其部署在 NVIDIA DGX Cloud 等其他加速云或者數據中心基礎設施上。

這是 AI 時代的計算機。

DGX Spark 系統現已開放預訂,而 DGX Station 預計將由華碩、戴爾、惠普等合作伙伴于今年晚些時候推出。

下一代 AI 芯片 Rubin 官宣,2026 年下半年推出

英偉達一直以科學家的名字為其架構命名,這種命名方式已成為英偉達文化的一部分。這一次,英偉達延續了這一慣例,將下一代 AI 芯片平臺命名為「Vera Rubin」,以紀念美國著名天文學家薇拉·魯賓(Vera Rubin)。

黃仁勛表示,Rubin 的性能將達到 Hopper 的 900 倍,而 Blackwell 相較 Hopper 已實現了 68 倍的提升。

其中,Vera Rubin NVL144 預計將在 2026 年下半年發布。參數信息省流不看版:

- 3.6 EF FP4 Inference:在進行 FP4 精度的推理任務時,能夠達到 3.6 ExaFLOPS(每秒百億億次浮點運算)。

- 1.2 EF FP8 Training:在進行 FP8 精度的訓練任務時,性能為 1.2 ExaFLOPS。

- 3.3X GB300 NVL72:與 GB300 NVL72 相比,性能提升了 3.3 倍。

- 13 TB/s HBM4:配備了 HBM4,帶寬為 13TB/s。

- 75 TB Fast Memory:擁有 75 TB 的快速內存,是前代的 1.6 倍。

- 260 TB/s NVLink6:支持 NVLink 6,帶寬為 260 TB/s,是前代的 2 倍。

- 28.8 TB/s CX9:支持 CX9,帶寬為 28.8 TB/s,是前代的 2 倍。

標準版 Rubin 將配備 HBM4,性能比當前的 Hopper H100 芯片大幅提升。

Rubin 引入名為 Grace CPU 的繼任者——Veru,包含 88 個定制的 Arm 核心,每個核心支持 176 個線程,并通過 NVLink-C2C 實現 1.8 TB/s 的高帶寬連接。

英偉達表示,定制的 Vera 設計將比去年 Grace Blackwell 芯片中使用的 CPU 速度提升一倍。

與 Vera CPU 搭配時,Rubin 在推理任務中的算力可達 50 petaflops,是 Blackwell 20 petaflops 的兩倍以上。此外,Rubin 還支持高達 288GB 的 HBM4 內存,這也是 AI 開發者關注的核心規格之一。

實際上,Rubin 由兩個 GPU 組成,而這一設計理念與當前市場上的 Blackwell GPU 類似——后者也是通過將兩個獨立芯片組裝為一個整體運行。

從 Rubin 開始,英偉達將不再像對待 Blackwell 那樣把多 GPU 組件稱為單一 GPU,而是更準確地按照實際的 GPU芯 片裸片數量來計數。

互聯技術也升級了,Rubin 配備第六代 NVLink,以及支持 1600 Gb/s 的 CX9 網卡,能夠加速數據傳輸并提升連接性。

除了標準版 Rubin,英偉達還計劃推出 Rubin Ultra 版本。

Rubin Ultra NVL576 則將于 2027 年下半年推出。參數細節如下:

- 15 EF FP4 Inference:在 FP4 精度下進行推理任務時,性能達到 15 ExaFLOPS。

- 5 EF FP8 Training:在 FP8 精度下進行訓練任務時,性能為 5 ExaFLOPS。

- 14X GB300 NVL72:相比 GB300 NVL72,性能提升 14 倍。

- 4.6 PB/s HBM4e:配備 HBM4e 內存,帶寬為 4.6 PB/s。

- 365 TB Fast Memory:系統擁有 365 TB 的快速內存,是前代的 8 倍。

- 1.5 PB/s NVLink7:支持 NVLink 7,帶寬為 1.5 PB/s,是前代的 12 倍。

- 115.2 TB/s CX9:支持 CX9,帶寬為 115.2 TB/s,是前代的 8 倍。

在硬件配置上,Rubin Ultra 的 Veras 系統延續了 88 個定制 Arm 核心的設計,每個核心支持 176 個線程,并通過 NVLink-C2C 提供 1.8 TB/s 的帶寬。

而 GPU 方面,Rubin Ultra 集成了 4 個 Reticle-Sized GPU,每顆 GPU 提供 100 petaflops 的 FP4 計算能力,并配備 1TB 的 HBM4e 內存,在性能和內存容量上都達到了新的高度。

為了在瞬息萬變的市場競爭中站穩腳跟,英偉達的產品發布節奏已經縮短至一年一更。發布會上,老黃也正式揭曉下一代 AI 芯片的命名——物理學家費曼(Feynman)。

隨著 AI 工廠的規模不斷擴大,網絡基礎設施的重要性愈發凸顯。

為此,英偉達推出了 Spectrum-X

和 Quantum-X 硅光網絡交換機,旨在幫助 AI 工廠實現跨站點連接數百萬 GPU,同時顯著降低能耗和運營成本。

Spectrum-X Photonics 交換機具有多種配置,包括:

- 128 端口 800Gb/s或 512 端口 200Gb/s 配置,總帶寬達 100Tb/s

- 512 端口 800Gb/s或 2048 端口200Gb/s配置,總吞吐量達 400Tb/s

與之配套的 Quantum-X Photonics 交換機則基于 200Gb/s SerDes 技術,提供 144 端口 800Gb/s 的 InfiniBand 連接,并采用液冷設計高效冷卻板載硅光子組件

與上一代產品相比,Quantum-X Photonics 交換機為 AI 計算架構提供 2 倍速度和 5 倍可擴展性。

Quantum-X Photonics InfiniBand 交換機預計于今年晚些時候上市,而 Spectrum-X Photonics 以太網交換機預計將于 2026 年推出。

隨著 AI 的快速發展,對數據中心的帶寬、低延遲和高能效需求也急劇增加。

英偉達 Spectrum-X Photonics 交換機采用了一種名為 CPO 的光電子集成技術。其核心是將光引擎(就是能處理光信號的芯片)和普通的電子芯片(比如交換芯片或 ASIC 芯片)放在同一個封裝里。

這種技術的好處很多:

- 傳輸效率更高:因為距離縮短,信號傳輸更快。

- 功耗更低:距離短了,傳輸信號需要的能量也少了。

- 體積更小:把光和電的部件集成在一起,整體體積也變小了,空間利用率更高。

AI 工廠的「操作系統」Dynamo

未來將沒有數據中心,只有 AI 工廠。

黃仁勛表示,未來,每個行業、每家公司擁有工廠時,都將有兩個工廠:一個是他們實際生產的工廠,另一個是 AI 工廠,而 Dynamo 則是專門為「AI 工廠」打造的操作系統。

Dynamo 是一款分布式推理服務庫,為需要 token 但又無法獲得足夠 token 的問題提供開源解決方案。

簡單來說,Dynamo 有四個方面的優勢:

- GPU 規劃引擎,動態調度 GPU 資源以適應用戶需求

- 智能路由器,減少 GPU 對重復和重疊請求的重新計算,釋放更多算力應對新的傳入請求

- 低延遲通信庫,加速數據傳輸

- 內存管理器,智能在低成本內存和存儲設備中的推理數據

人形機器人的露臉環節,永遠不會缺席

人形機器人再一次成為了 GTC 大會的壓軸節目,這次英偉達帶來了 Isaac GR00T N1,全球首款開源人形機器人功能模型。